17 changed files with 78 additions and 26 deletions

+ 69

- 20

README.md

View File

+ 2

- 0

benchmarks/db_bench.cc

View File

+ 6

- 5

benchmarks/db_bench_FieldDB.cc

View File

+ 1

- 1

fielddb/field_db.h

View File

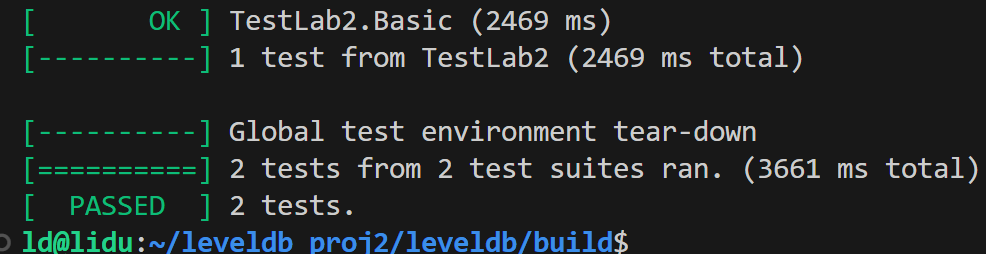

BIN

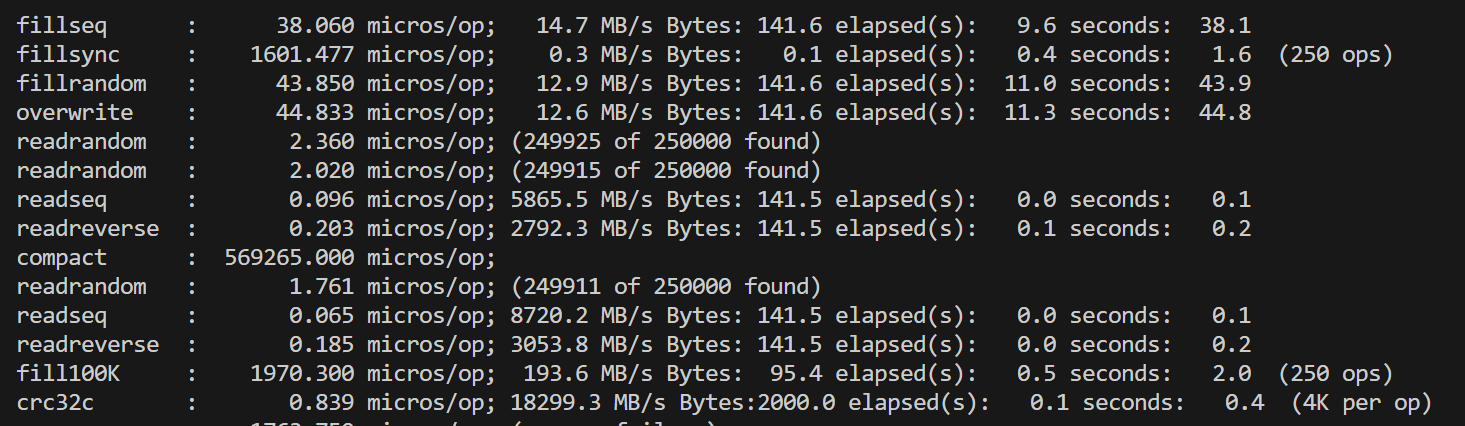

pics/basic.png

View File

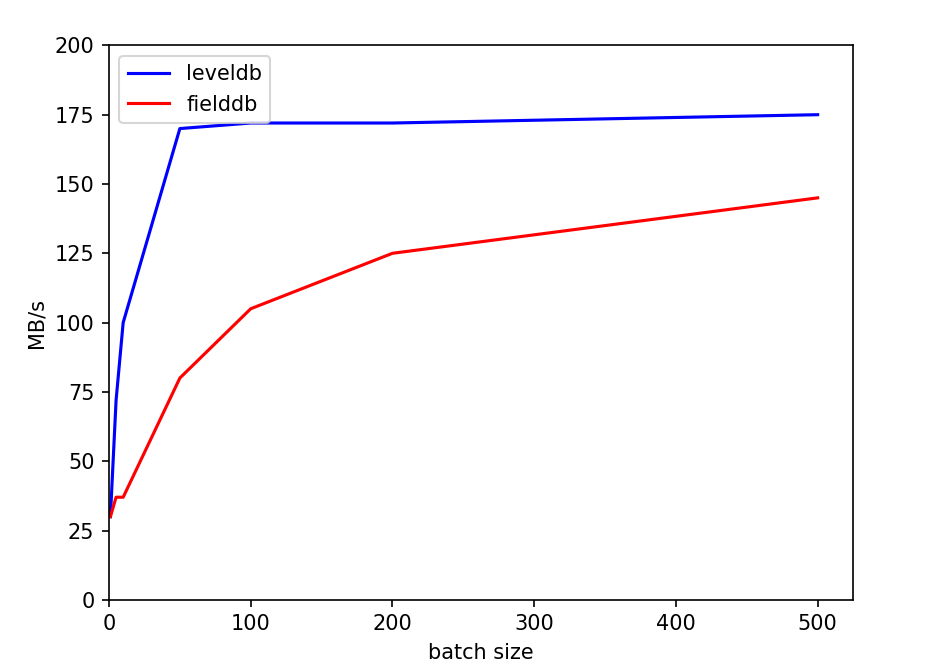

BIN

pics/f_bsize.png

View File

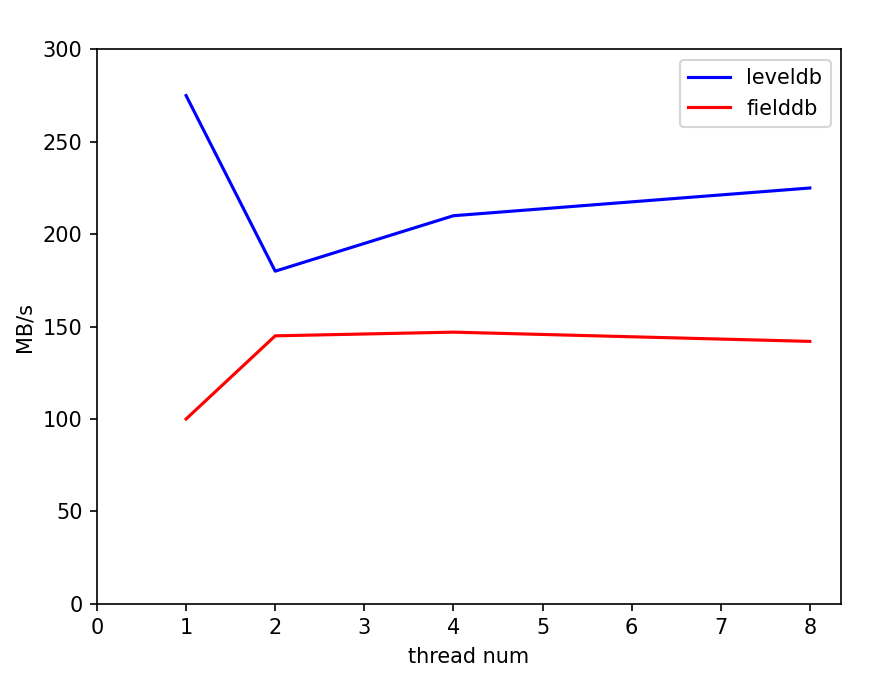

BIN

pics/f_thread.png

View File

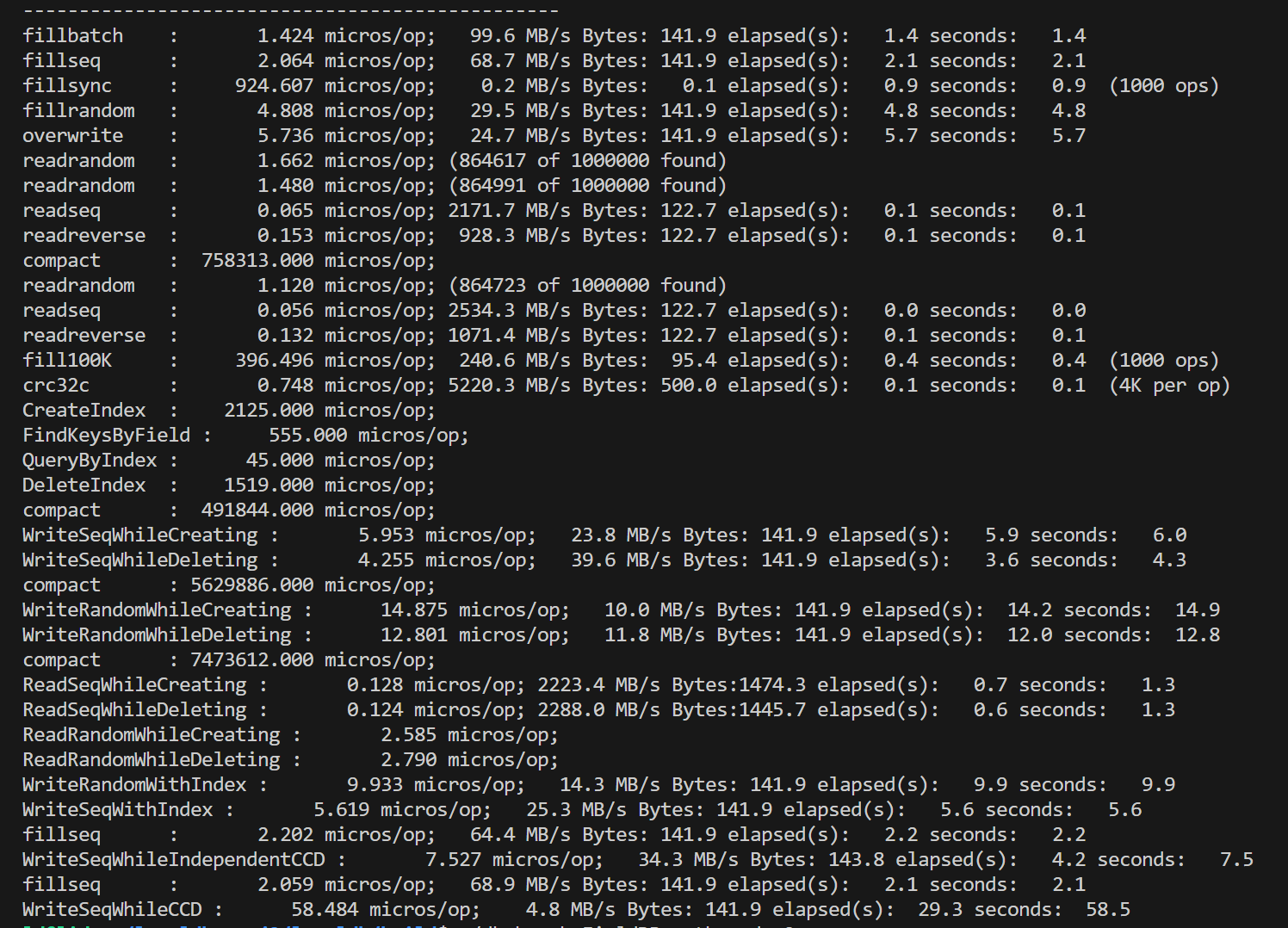

BIN

pics/field单.png

View File

BIN

pics/field双.png

View File

BIN

pics/fillbatch.png

View File

BIN

pics/level单.png

View File

BIN

pics/level双.png

View File

BIN

pics/level四.png

View File

BIN

pics/parallel.png

View File

BIN

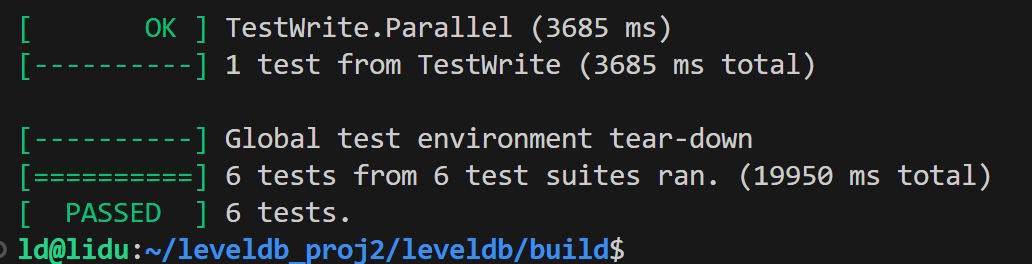

pics/q&m_bsize.png

View File

BIN

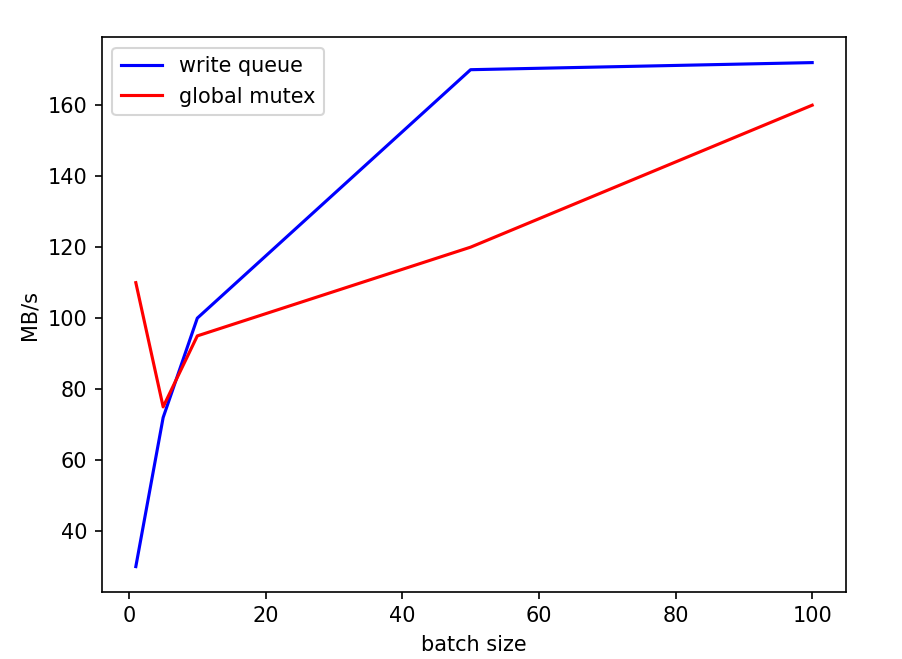

pics/queue&mutex.png

View File

BIN

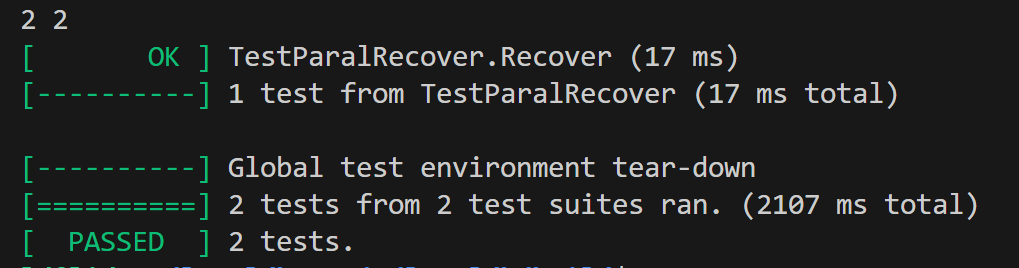

pics/reover.png

View File

Loading…